張文宏“被AI帶貨”,監(jiān)管如何跟上技術(shù)發(fā)展,?

“張文宏是不是帶貨了,?”最近,有網(wǎng)友稱在網(wǎng)絡(luò)賣貨視頻中看到知名醫(yī)生張文宏在售賣一種蛋白棒產(chǎn)品,。不過,,經(jīng)常刷短視頻的朋友很快就能分辨出這是AI合成的視頻,并非本人,。

隨著人工智能技術(shù)的迅猛發(fā)展,,AI換臉已經(jīng)能夠做到以假亂真。當(dāng)AI技術(shù)被不當(dāng)使用,,用戶該如何識(shí)破騙局,?監(jiān)管如何跟上技術(shù)發(fā)展?

張文宏回應(yīng)“被AI帶貨”:已多次投訴但違規(guī)賬號(hào)屢禁不止

在帶貨視頻中,,被合成的人像反復(fù)介紹一種產(chǎn)品,,聲音聽起來很像張文宏本人,。一些老人信以為真,不僅下了單,,還呼朋引伴來購買,。對(duì)此,張文宏回應(yīng)稱,,這樣的賣貨賬號(hào)不止一個(gè),,而且一直在變,他多次向平臺(tái)投訴但屢禁不絕,。

目前,,用語音合成來模仿他人聲音,生成視頻的技術(shù)已經(jīng)非常成熟,,甚至僅用一張照片就能生成此類視頻,。

工信部信息通信經(jīng)濟(jì)專家委員會(huì)委員盤和林表示:“AI技術(shù)冒充名人帶貨、詐騙越來越多,,這里的關(guān)鍵不在AI,,而是要及時(shí)處理利用AI冒充他人的內(nèi)容發(fā)布者。冒名頂替,、虛假宣傳,、破壞名人肖像權(quán)、利用名人的公信力來牟利,,這些行為會(huì)給名人帶來風(fēng)險(xiǎn),,也會(huì)成為詐騙分子的溫床?!?/p>

工信部反詐工作專班專家李坤介紹,,在網(wǎng)上,,耳聽眼見不一定為實(shí),。“擬聲”“換臉”等合成技術(shù)的一大特點(diǎn)是以假亂真,,不法分子可以利用此類技術(shù)輕易偽裝成他人,,并通過快速篩選目標(biāo)人群、精準(zhǔn)制定詐騙腳本,。

“不法分子通過各種公開渠道獲取受害人的個(gè)人肖像或視頻,,然后利用AI技術(shù)對(duì)受害人面容特征進(jìn)行學(xué)習(xí),模仿眨眼,、搖頭等動(dòng)作,,實(shí)現(xiàn)以假亂真的效果?!崩罾ふf,。

推薦閱讀

暑假去哪兒玩,?體驗(yàn)一下“去建設(shè)火星,!”

央視新聞客戶端2025-07-21 08:42:14

網(wǎng)友:我的外賣,,可能是未來戰(zhàn)機(jī)飛行員送的!

央視軍事2025-07-20 15:27:18

警惕,!這些沒有“出生證明”的玩具暗藏風(fēng)險(xiǎn)

央視新聞客戶端2025-07-20 14:59:47

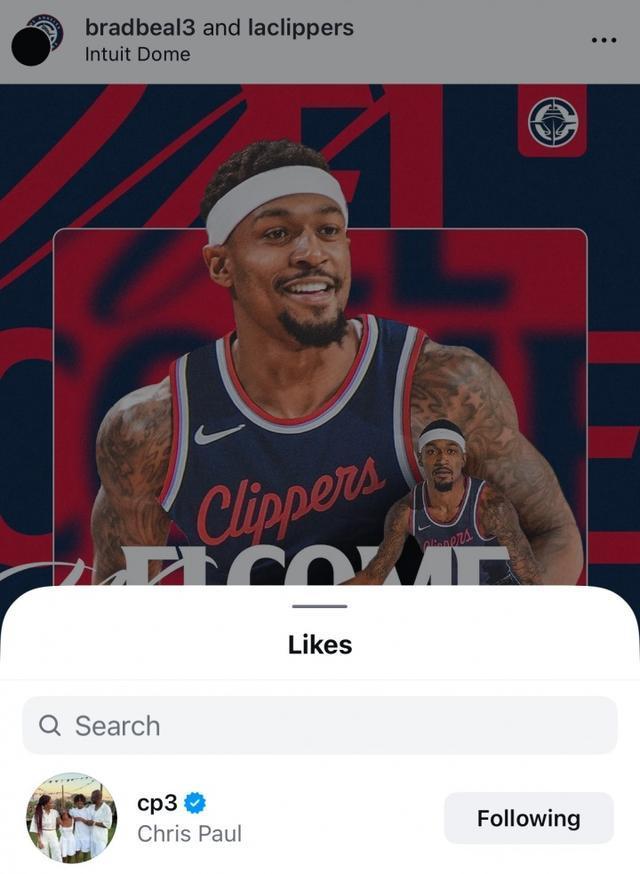

快船官方曬海報(bào)迎接比爾加盟 保羅點(diǎn)贊歡迎

鳳凰網(wǎng)2025-07-21 15:12:43

柯文哲妻子首次表態(tài)反罷免 支持反惡罷

海峽導(dǎo)報(bào)2025-07-21 14:41:30

北約揚(yáng)言“拿下”加里寧格勒 逼近俄羅斯核心利益區(qū)

頭條2025-07-21 14:25:51

石破茂表示繼續(xù)擔(dān)任首相 確保政治運(yùn)作不陷入停滯

中國(guó)新聞網(wǎng)2025-07-21 15:11:27

在建世界第一高橋通車倒計(jì)時(shí) 橋旅融合新典范

新浪2025-07-21 15:10:57

女孩囤積大量吧唧深夜中毒緊急送醫(yī) 二次元收藏引發(fā)健康隱患

手機(jī)光明網(wǎng)2025-07-21 15:19:34

巴基斯坦梟龍戰(zhàn)機(jī)斬獲大獎(jiǎng),,斬獲雙獎(jiǎng)!

頭條2025-07-21 14:42:38

女方不喊老公男子希望退回彩禮 婚姻破裂引爭(zhēng)議

極目新聞2025-07-21 15:07:22

熱死的不止蚊子,!全球41%兩棲動(dòng)物拉響滅絕警報(bào) 極端氣候加劇瀕危趨勢(shì)

騰訊2025-07-21 15:13:09

男子嫌妻子開車慢 當(dāng)街打斷其肋骨 家暴行為被判刑

魯網(wǎng)2025-07-21 15:04:30

專家:柬方借與泰邊境糾紛強(qiáng)化軍力 政治棋局背后

包明說2025-07-21 14:15:12

美國(guó)洛杉磯一車輛沖撞人群 至少28人受傷

央視新聞2025-07-21 15:17:49

巴基斯坦“梟龍”戰(zhàn)機(jī)斬獲大獎(jiǎng) 展示卓越飛行技術(shù)

火線前沿2025-07-21 14:41:49

香奈兒否認(rèn)自己是扁平足,,脫鞋自證引發(fā)全場(chǎng)爆笑

微博2025-07-21 15:07:57

特朗普簽署《天才法案》 穩(wěn)定幣監(jiān)管框架確立

光明網(wǎng)2025-07-21 15:11:58

韓男子尾隨前女友破窗而入:要是敢大叫我就跳樓

新浪2025-07-21 15:02:17

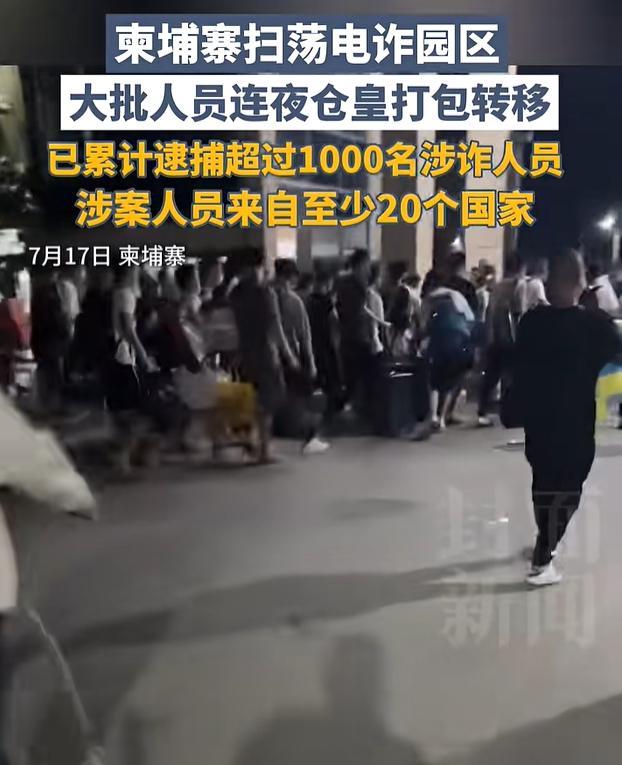

柬埔寨突擊檢查詐騙窩點(diǎn) 逮捕2270名嫌疑人

每日經(jīng)濟(jì)新聞2025-07-21 15:17:23

美國(guó)新型狼群系列廉價(jià)導(dǎo)彈靠譜嗎,?直升機(jī)打052D?,?

頭條2025-07-21 14:47:12

專家:中國(guó)或成杜特爾特翻盤關(guān)鍵

頭條2025-07-21 14:39:44

李在明止步中國(guó)行,,沒等到美國(guó)的表揚(yáng),,反遭到朝鮮無預(yù)警“水攻” 韓國(guó)尷尬應(yīng)對(duì)

www.163.com2025-07-21 15:15:37

印度反對(duì)黨領(lǐng)袖呼吁變革 推動(dòng)基層變革

觀察者網(wǎng)2025-07-21 14:16:35

農(nóng)村新公廁為何成擺設(shè) 建而不用引質(zhì)疑

百家號(hào)2025-07-21 15:20:55

新一輪臺(tái)風(fēng)周三起影響我國(guó) 夏季天氣主角登場(chǎng)

北晚在線2025-07-21 15:08:26

當(dāng)?shù)鼗貞?yīng)深圳環(huán)衛(wèi)工臺(tái)風(fēng)天清理樹枝 職責(zé)所在安全搶險(xiǎn)

騰訊網(wǎng)2025-07-21 15:04:02

家里“吧唧”太多 女孩深夜中毒送醫(yī) 二次元收藏需謹(jǐn)慎

極目新聞2025-07-21 15:06:52

以色列總理食物中毒 貪腐案聽證會(huì)延期至9月

光明網(wǎng)2025-07-21 15:13:25

美國(guó)為啥死磕伊朗核問題 雙重標(biāo)準(zhǔn)下的地緣政治博弈

搜狐軍事2025-07-21 14:37:28

小學(xué)生課上被燒傷 百萬治療費(fèi)誰負(fù)責(zé) 校方承諾與現(xiàn)實(shí)差距

環(huán)球網(wǎng)2025-07-21 15:19:08

高鐵一次性座套火了 12306:暫不售賣 出行神器受追捧

界面新聞2025-07-21 15:02:45

快船總裁:考慮簽克里斯保羅 強(qiáng)烈意向浮出水面

北青網(wǎng)2025-07-21 15:17:12

加沙有數(shù)百人爭(zhēng)著要?dú)埜o?只為給家人換來一口食物

頭條2025-07-21 15:07:34

印度兩兄弟與同一女子結(jié)婚現(xiàn)場(chǎng)畫面 遵循部落傳統(tǒng)的婚禮

極目新聞2025-07-21 15:06:21