2B多模態(tài)新SOTA,華科,、華南理工發(fā)布Mini-Monkey,,專治“切分增大分辨率”后遺癥

2B多模態(tài)新SOTA,華科,、華南理工發(fā)布Mini-Monkey,,專治“切分增大分辨率”后遺癥

近期,多模態(tài)大模型處理高分辨率圖像的性能優(yōu)化成為了研究熱點,。以往的多數(shù)方法集中于圖像切分與融合策略,,以增強(qiáng)模型對圖像細(xì)節(jié)的理解,但這種做法可能導(dǎo)致目標(biāo)和連續(xù)區(qū)域的割裂,,尤其是在文檔理解任務(wù)中,,文字?jǐn)嗔训膯栴}尤為突出。

針對這一難題,,華中科技大學(xué)與華南理工大學(xué)合作推出了一款名為Mini-Monkey的輕量級多模態(tài)大模型,。該模型創(chuàng)新性地采用了多尺度自適應(yīng)切分策略(MSAC)和尺度壓縮機(jī)制(SCM),有效解決了傳統(tǒng)圖像切分策略的弊端,,顯著提升了模型在高分辨率圖像和文檔理解任務(wù)上的性能,。Mini-Monkey在多個基準(zhǔn)測試中均取得了領(lǐng)先地位,充分展示了其在多模態(tài)理解與文檔智能領(lǐng)域的潛力,。

MSAC策略讓Mini-Monkey能夠自動生成多尺度的圖像表示,,確保模型能從不同尺度中識別完整的對象,避免了因切分造成的識別障礙,。而SCM則是一種無參數(shù)的機(jī)制,,用于在保持高效計算的同時,篩選出關(guān)鍵的視覺特征,,進(jìn)一步優(yōu)化了模型的效率和性能,。

實驗結(jié)果顯示,Mini-Monkey不僅在文檔智能任務(wù)上取得了優(yōu)異成績,,還在廣泛的多模態(tài)理解任務(wù)中實現(xiàn)了性能提升,,與更大參數(shù)量的模型相比,如GLM-4v-9B,Mini-Monkey在OCRBench測試中得分高達(dá)802,,展現(xiàn)出其作為2B參數(shù)量模型的頂尖狀態(tài),。

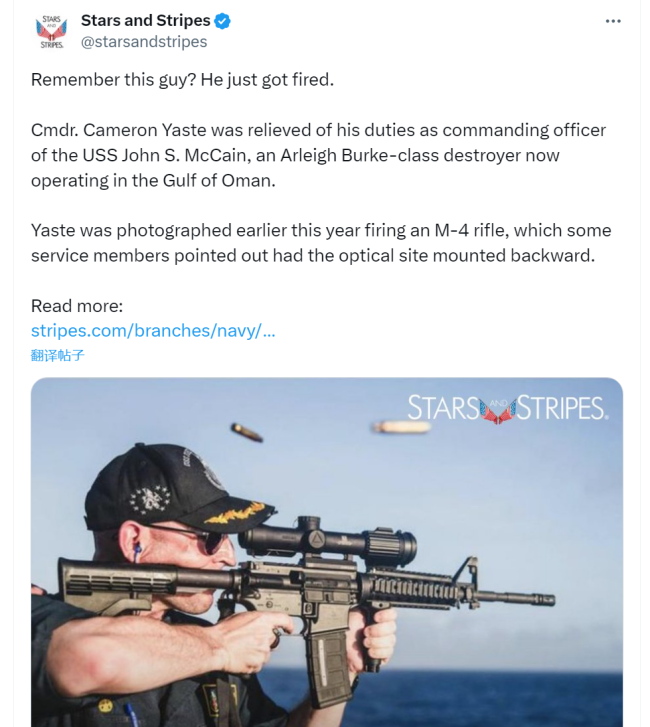

研究還通過與其他切分策略的對比,證明了MSAC策略的有效性和普適性,,它能夠顯著減少因圖像切分造成的語義不連貫,,如對象識別錯誤和文字分割不當(dāng)?shù)葐栴}。Mini-Monkey在處理包含復(fù)雜,、模糊文本的古籍圖像時,,相較于MiniCPM-V 2.6、InternVL2-2B和GPT-4o等模型,,展現(xiàn)出了更準(zhǔn)確的文本提取能力,。

綜上,Mini-Monkey模型及其采用的MSAC與SCM技術(shù),,為多模態(tài)大模型在處理高分辨率圖像和提高文檔理解能力方面提供了一個新的,、高效的研究方向,標(biāo)志著在克服傳統(tǒng)切分策略局限性上邁出的重要一步,。

2B多模態(tài)新SOTA,,華科、華南理工發(fā)布Mini-Monkey,,專治“切分增大分辨率”后遺癥,。

相關(guān)新聞

OpenAI發(fā)布全新生成式AI模型GPT-4o 交互革新,,實時多模態(tài)引熱議

5月14日,,OpenAI在春季發(fā)布會上揭曉了其最新的旗艦AI模型——GPT-4o,這一模型以“全知全能”為目標(biāo),,實現(xiàn)了實時的語音,、文本、圖像交互功能

2024-05-15 09:10:07OpenAI發(fā)布全新生成式AI模型GPT-4oGPT-4o為OpenAI開啟超級入口 多模態(tài)交互新時代,?

隨著OpenAI在2024年5月14日的展示,,GPT-4o這一多模態(tài)大模型產(chǎn)品進(jìn)入了公眾視野,標(biāo)志著信息獲取方式可能迎來變革

2024-05-15 08:45:10GPT-4o為OpenAI開啟超級入口張立群不再擔(dān)任華南理工校長 唐洪武接任新校長

2024-08-30 16:32:15張立群不再擔(dān)任華南理工校長阿里發(fā)通用多模態(tài)大模型mPLUG-Owl3 4秒看完2小時電影

阿里mPLUG團(tuán)隊近期發(fā)布了一項新成果——通用多模態(tài)大模型mPLUG-Owl3,,這款模型專為理解復(fù)雜多圖和長視頻內(nèi)容設(shè)計

2024-08-19 17:47:52阿里發(fā)通用多模態(tài)大模型mPLUG-Owl3大地磁暴預(yù)警發(fā)布 會產(chǎn)生哪些影響 衛(wèi)星導(dǎo)航誤差增大

2024-03-25 13:10:14大地磁暴預(yù)警發(fā)布天才創(chuàng)始人對談AI教父Hinton:多模態(tài)是AI的未來,,醫(yī)療將發(fā)揮AI最大的潛力

2024-05-21 20:45:29天才創(chuàng)始人對談AI教父Hinton:多模態(tài)是AI的未來