美學(xué)者解析DeepSeek技術(shù)原理 揭秘低成本高效模型背后的秘密

2025年蛇年春節(jié)前夕,DeepSeek徹底出圈,。1月27日,,DeepSeek應(yīng)用登頂蘋果美國地區(qū)應(yīng)用商店免費(fèi)App下載排行榜,,在美區(qū)下載榜上超越了ChatGPT。同日,,蘋果中國區(qū)應(yīng)用商店免費(fèi)榜顯示,DeepSeek成為中國區(qū)第一。

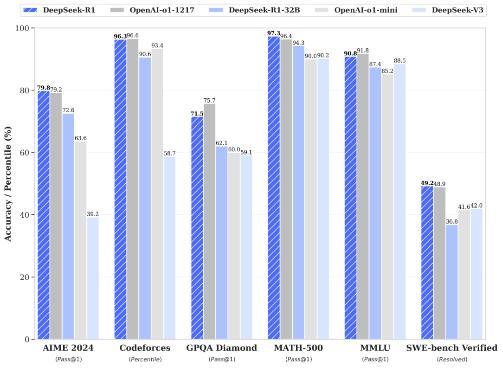

浙江大學(xué)計(jì)算機(jī)博士,、美國南加州大學(xué)訪問學(xué)者傅聰解析了DeepSeek成功背后的技術(shù)原理。業(yè)界對(duì)DeepSeek的喜愛主要集中在三個(gè)方面:技術(shù)層面,,DeepSeek背后的DeepSeek-V3及新推出的DeepSeek-R1兩款模型分別實(shí)現(xiàn)了與OpenAI 4o和o1模型相當(dāng)?shù)哪芰?;成本方面,這兩款模型的成本僅為OpenAI 4o和o1模型的十分之一左右,;此外,,DeepSeek還開源了這些模型,讓更多的AI團(tuán)隊(duì)能夠基于先進(jìn)且低成本的模型開發(fā)更多AI原生應(yīng)用,。

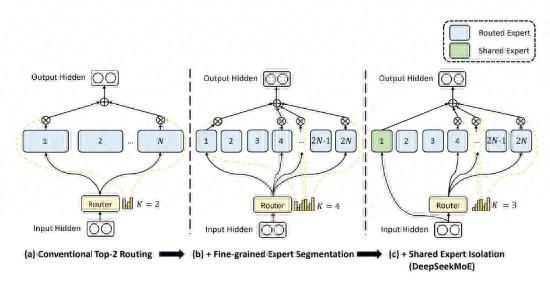

關(guān)于如何實(shí)現(xiàn)模型成本降低同時(shí)保證效果,,傅聰表示,DeepSeek通過Multi-Head latent Attention(MLA)和DeepSeek MOE架構(gòu)節(jié)省了大量的顯存,,從而高效利用底層算力,,以更低的成本訓(xùn)練出更出色的模型。具體而言,,DeepSeek采用了一種不需要輔助損失函數(shù)的專家加載均衡技術(shù),,確保每個(gè)token下少量專家網(wǎng)絡(luò)參數(shù)被激活時(shí),不同專家網(wǎng)絡(luò)能以更均衡的頻率被激活,。這種策略在DeepSeek V2版本中已經(jīng)驗(yàn)證有效,,并在6710億參數(shù)規(guī)模的DeepSeek V3中進(jìn)一步驗(yàn)證,,接近頭部玩家目前最好的商用模型參數(shù)規(guī)模。

DeepSeek還設(shè)計(jì)了一種“對(duì)偶流水線”機(jī)制,,通過極致的流水線調(diào)度,,將GPU用于數(shù)學(xué)運(yùn)算和通信相關(guān)的算力進(jìn)行并行隱藏,使得GPU幾乎不間斷地進(jìn)行運(yùn)算,,理論上可使GPU指令執(zhí)行流水線中的“氣泡”減少一半,。此外,DeepSeek限制了每個(gè)token發(fā)送到GPU集群節(jié)點(diǎn)的數(shù)量,,保持較低的通信開銷,,并應(yīng)用了FP8混合精度訓(xùn)練架構(gòu),靈活使用不同精度的數(shù)字表示,,加快計(jì)算速度并降低通信開銷,。

除了成本優(yōu)化,DeepSeek還提升了模型效果,。DeepSeek應(yīng)用了多token預(yù)測(cè)技術(shù),,使模型在訓(xùn)練時(shí)同時(shí)預(yù)測(cè)序列后面更遠(yuǎn)位置的token,增強(qiáng)了模型對(duì)未來感知能力,。真正幫助DeepSeek追趕o1的是最新模型DeepSeek-R1,,該模型幾乎單純使用強(qiáng)化學(xué)習(xí)技術(shù)進(jìn)行“后訓(xùn)練”,極大提升了推理能力,。R1模型通過學(xué)習(xí)CoT(思維鏈)的方式逐步推理得出結(jié)果,,而不是直接預(yù)測(cè)答案。這一方案驗(yàn)證了強(qiáng)化學(xué)習(xí)及inference time scaling law的可行性,,證明小模型也能通過CoT + RL大幅提升推理能力,,具備應(yīng)用場(chǎng)景落地潛力。R1的出現(xiàn)還將增加學(xué)界和產(chǎn)業(yè)界對(duì)合成數(shù)據(jù)的需求,。

相關(guān)新聞

美媒:DeepSeek如何威脅美國主導(dǎo)地位 低成本高效率挑戰(zhàn)硅谷

2025-01-27 10:50:53美媒DeepSeek被美國科技圈盯上了 技術(shù)黑馬崛起引發(fā)美國科技圈關(guān)注

2025-01-26 17:43:50DeepSeek被美國科技圈盯上了DeepSeek在美區(qū)下載榜超越ChatGPT 中美兩地旋風(fēng)式崛起

DeepSeek掀起的大模型旋風(fēng)在中美兩地愈演愈烈。1月27日,,蘋果App Store中國區(qū)免費(fèi)榜顯示,,DeepSeek登上首位

2025-01-28 03:14:39DeepSeek在美區(qū)下載榜超越ChatGPTDeepSeek登頂蘋果美區(qū)免費(fèi)下載榜 國產(chǎn)大模型崛起

2025-01-27 09:12:14DeepSeek登頂蘋果美區(qū)免費(fèi)下載榜實(shí)測(cè)DeepSeek做奧數(shù)題寫作文 DeepSeek火爆全球

2025-01-27 20:13:31實(shí)測(cè)DeepSeek做奧數(shù)題寫作文DeepSeek掀翻美科技股 英偉達(dá)大跌 AI競(jìng)爭(zhēng)格局生變

2025-01-27 22:02:59DeepSeek掀翻美科技股英偉達(dá)大跌