梁文鋒“反對”張一鳴 小力出奇跡挑戰(zhàn)大力神話(2)

Janus-Pro的成本相對較低,使用輕量級分布式訓(xùn)練框架,1.5B參數(shù)模型大約需要128張英偉達(dá)A100芯片訓(xùn)練7天,,7B參數(shù)模型則需要256張A100芯片和14天訓(xùn)練時間,。這樣計算下來,模型訓(xùn)練成本可低至數(shù)萬美元,。性能方面,Janus-Pro通過將多模態(tài)理解和生成統(tǒng)一起來,提升了視覺編碼解耦的能力,。在實際應(yīng)用中,無論是文生圖還是圖生文,,Janus-Pro都表現(xiàn)良好,。

Janus-Pro繼承了DeepSeek的開源傳統(tǒng),使用MIT協(xié)議,,個人和中小企業(yè)可以省去不少費用,。此外,,由于模型體量小,Janus-Pro可以在PC端安裝并本地運行,,進一步降低了使用成本,。

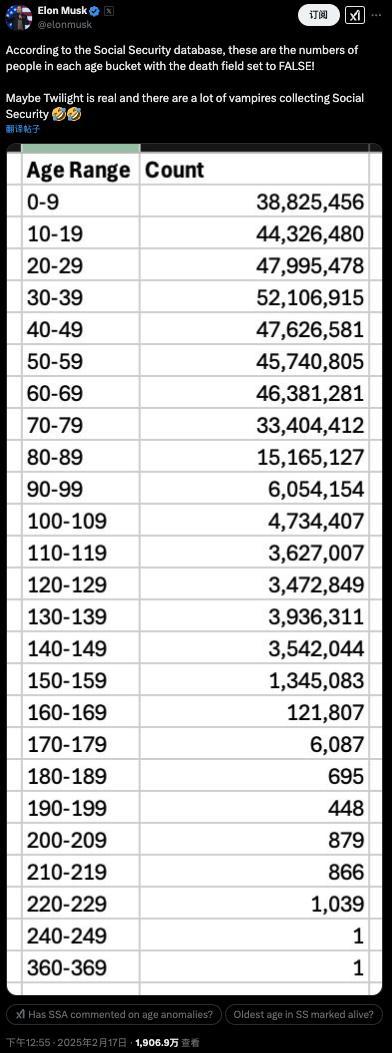

相比之下,國外秉持“大力出奇跡”的OpenAI近期遇到一些問題,。例如,,其文生視頻大模型Sora雖然震撼亮相,但隨后效果不盡如人意,,被谷歌等競爭對手抓住機會嘲諷,。盡管如此,OpenAI仍堅持堆芯片,、堆算力的路線,,計劃未來四年投資5000億美元用于AI基礎(chǔ)設(shè)施。

字節(jié)跳動的核心產(chǎn)品豆包大模型在知識,、代碼,、推理等多項公開測評基準(zhǔn)上得分優(yōu)于GPT-4o和DeepSeek-V3,但其投入同樣驚人,。據(jù)傳今年將投入超過120億美元用于AI基礎(chǔ)設(shè)施,,不過字節(jié)對此回應(yīng)稱相關(guān)消息并不準(zhǔn)確。

DeepSeek通過“小力出奇跡”的方式展示了新的技術(shù)路線和商業(yè)哲學(xué),,打破了傳統(tǒng)的大廠主導(dǎo)邏輯,。這表明中小廠商完全可以用更少的資源做出更好的產(chǎn)品,從而得到市場和投資者的認(rèn)可,。

相關(guān)新聞

DeepSeek梁文鋒的“第一桶金”

2025-02-08 01:17:07DeepSeek梁文鋒的“第一桶金”DeepSeek梁文鋒的“第一桶金” 量化交易積累資本

2025-02-08 01:40:40DeepSeek梁文鋒的第一桶金DeepSeek融資?梁文鋒“打太極” 估值分歧巨大

2025-02-14 14:18:12DeepSeek融資AI估值引熱議,!DeepSeek梁文鋒身家暴漲

在科技領(lǐng)域風(fēng)起云涌的今天,,一家名為DeepSeek的AI公司突然成為了全球關(guān)注的焦點

2025-02-11 14:32:25DeepSeek梁文鋒身家暴漲DeepSeek梁文鋒實習(xí)時月薪16000元 技術(shù)新星初露鋒芒

2025-02-11 09:09:46DeepSeek梁文鋒實習(xí)時月薪16000元DeepSeek梁文鋒曾在上海實習(xí) 初展技術(shù)才華

2025-02-10 13:10:19DeepSeek梁文鋒曾在上海實習(xí)