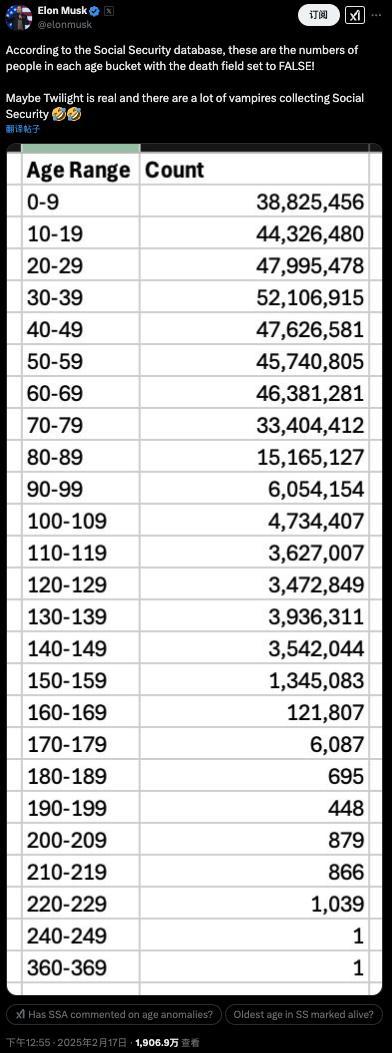

關(guān)于DeepSeek 馬斯克評論了兩條帖子 AI將無處不在

馬斯克評論稱:“有趣的分析,。我所見過的最好的?!薄癆I 將無處不在,。”

關(guān)于 DeepSeek r1 的真相與細節(jié),,該應(yīng)用在相關(guān) App Store 類別中下載量排名第一,,領(lǐng)先于 ChatGPT,并且超過了 Gemini 和 Claude 的表現(xiàn),。從質(zhì)量角度看,,它與 o1 相當(dāng),但不及 o3,。r1 實現(xiàn)了真正的算法突破,,在訓(xùn)練和推理方面都顯著提高了效率。FP8 訓(xùn)練,、MLA 和多 token 預(yù)測都有重要意義,。盡管其訓(xùn)練成本僅為 600 萬美元,但這數(shù)字可能具有誤導(dǎo)性,。即使硬件架構(gòu)新穎,,值得注意的是他們使用 PCI-Express 進行擴展。

根據(jù)技術(shù)論文,,600 萬美元并不包括前期研究和架構(gòu),、算法及數(shù)據(jù)消融實驗的成本。這意味著只有在實驗室已經(jīng)在前期研究上投入數(shù)億美元并且能夠訪問更大規(guī)模集群的情況下,,才能以 600 萬美元的成本訓(xùn)練出 r1 質(zhì)量的模型,。DeepSeek 顯然擁有遠超 2048 個 H800 的算力;早期的一篇論文提到擁有 10000 個 A100 的集群,。一個同樣聰明的團隊不可能僅憑 600 萬美元就能啟動 2000 個 GPU 集群并從頭開始訓(xùn)練 r1,。大約 20% 的 Nvidia 收入來自新加坡,但 20% 的 Nvidia GPU 可能并不在新加坡,。存在大量的知識蒸餾,,如果沒有對 GPT-4o 和 o1 的無障礙訪問,他們可能無法完成這個訓(xùn)練,。限制前沿 GPU 的訪問權(quán)限卻不對中國蒸餾美國前沿模型的能力采取任何措施,,這顯然違背了出口限制的目的,。

DeepSeek r1 確實具有重要意義,尤其在推理成本上比 o1 低得多且效率更高,,這比 600 萬美元的訓(xùn)練成本更具意義,。r1 的每次 API 調(diào)用成本比 o1 低 93%,可以在高端工作站上本地運行,,而且似乎沒有遇到任何速率限制,。簡單計算一下,每 10 億個活躍參數(shù)在 FP8 下需要 1GB 的 RAM,,因此 r1 需要 37GB 的 RAM,。批處理大大降低了成本,更多的計算能力增加了每秒 token 數(shù),,所以云端推理仍然具有優(yōu)勢,。這里還存在真正的地緣政治動態(tài),“Stargate”之后發(fā)布并非巧合,。

相關(guān)新聞

馬斯克談DeepSeek xAI即將發(fā)布更強模型

2025-02-09 22:13:58馬斯克談DeepSeek楊華評論:關(guān)于中國足球的集體反思都是盲人摸象

2024-09-14 15:36:57楊華評論:關(guān)于中國足球的集體反思都是盲人摸象馬斯克評論中國機器狗產(chǎn)品 未來戰(zhàn)爭新趨勢

近日,,中國機器人創(chuàng)業(yè)公司宇樹科技發(fā)布了最新機器狗產(chǎn)品B2-W的演示視頻,,引起了全球關(guān)注。許多國外網(wǎng)友表示被中國的科技實力震撼

2024-12-29 13:21:43馬斯克評論中國機器狗產(chǎn)品OpenAI前研究員自殺 馬斯克評論 引發(fā)行業(yè)震動

2024-12-14 18:46:24OpenAI前研究員自殺馬斯克評論馬斯克為何成DeepSeek“頭號黑粉” 小力出奇跡的挑戰(zhàn)者

馬斯克的“仇人”名單上最近新增了中國AI創(chuàng)業(yè)公司DeepSeek,。過去一個月,,這家以少量資源開發(fā)出頂級性能R1開源大模型的公司持續(xù)受到全球關(guān)注

2025-01-31 13:48:55馬斯克為何成DeepSeek頭號黑粉馬斯克評論美國24年來最嚴(yán)重空難 質(zhì)疑FAA雇傭政策

2025-01-31 13:46:59馬斯克評論美國24年來最嚴(yán)重空難