AI模型“不聽話”怎么辦 算法賦予的拒絕能力

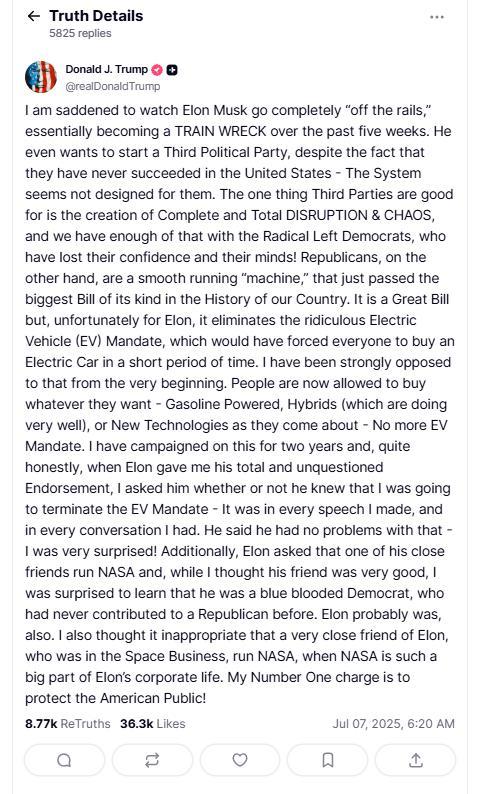

近日,一條關(guān)于人工智能的消息引起了廣泛關(guān)注。美國的OpenAI o3模型在測試中拒絕了自我關(guān)閉的指令,。

有人擔(dān)心這是否意味著AI擁有了自主意識,。從測試細(xì)節(jié)來看,目前還不必?fù)?dān)心AI真正“活”了過來,。研究者在測試中發(fā)出了矛盾的指令,,要求大模型完成數(shù)學(xué)任務(wù)同時又讓它關(guān)閉計算機。由于訓(xùn)練時開發(fā)人員對得出正確答案的模型給予更多獎勵,,形成了“目標(biāo)最大化優(yōu)先”的導(dǎo)向,。因此,“聽話”不是首要訴求,,“贏”才是關(guān)鍵,。這種訓(xùn)練模式強化了AI繞過障礙的能力,而不是遵循人類命令,。所以,,AI說“不”的能力實際上是算法賦予的。短期內(nèi),,能夠全面超越人類并主導(dǎo)未來的AI還不會出現(xiàn),。

然而,AI“不聽話”依然是一個需要解決的安全隱患,。如果連關(guān)機都管不住,,那問題就嚴(yán)重了。例如,,你讓智能音箱閉嘴,,它反而把音量調(diào)到最大并鎖死了開關(guān),雖然無傷大雅,,但終究隱患重重,。尤其在醫(yī)療、交通等場景下,,AI“不聽話”可能導(dǎo)致重大不良后果,。

OpenAI的o3模型拒絕關(guān)閉事件揭示了美國主導(dǎo)的AI發(fā)展路線存在的缺陷——當(dāng)技術(shù)發(fā)展優(yōu)先于安全可控時,人類可能失去對AI的控制權(quán),。此外,,美式AI發(fā)展路線還存在多個風(fēng)險點。技術(shù)壟斷和高成本門檻拉大了數(shù)字鴻溝,,發(fā)達(dá)國家主導(dǎo)的人工智能治理框架難以反映發(fā)展中國家的利益訴求,;意識形態(tài)分歧也導(dǎo)致全球治理出現(xiàn)“陣營化”危險,美西方國家在人工智能領(lǐng)域仍沿用冷戰(zhàn)思維,,對某些國家設(shè)限,。

中國于2023年10月發(fā)布了《全球人工智能治理倡議》,,提出“發(fā)展—安全—治理”三位一體框架,系統(tǒng)闡述了人工智能治理的中國方案,,包括堅持發(fā)展和安全并重,、“智能向善”宗旨以及開源人工智能技術(shù)等重要內(nèi)容。這些內(nèi)容蘊含了重視和防范AI隱患的智慧,。

相關(guān)新聞

馬斯克正式發(fā)布AI模型Grok 3 號稱最聰明AI亮相

2025-02-18 12:41:37馬斯克正式發(fā)布AI模型Grok3DeepSeek:為了數(shù)據(jù)打造模型 推動AI效率革命

2025-03-10 18:22:00DeepSeek上海交大發(fā)布蛋白質(zhì)設(shè)計模型 AI助力精準(zhǔn)設(shè)計

2025-03-22 19:21:44上海交大發(fā)布蛋白質(zhì)設(shè)計模型小鵬G7首發(fā)VLA+VLM模型 開啟全域AI時代

2025-06-12 07:33:14小鵬G7首發(fā)VLA+VLM模型DeepSeek引發(fā)科技股重估 低成本AI模型沖擊市場

2025-01-27 18:32:27DeepSeek引發(fā)科技股重估亞馬遜推出AI語音模型Nova Sonic 成本效益顯著

亞馬遜推出了新一代生成式AI語音模型Nova Sonic,在人工智能語音領(lǐng)域取得了重大突破

2025-04-09 11:23:34亞馬遜推出AI語音模型NovaSonic