人工智能為何會產(chǎn)生幻覺 自信的謊言家背后

在科幻電影中,人工智能常被塑造成全知全能的“超級大腦”,,但現(xiàn)實中,,AI卻時常表現(xiàn)為“自信的謊言家”,。比如,,請AI描述“關公戰(zhàn)秦瓊”,,它不僅能“敘述”虛構的故事情節(jié),,還會“猜測”用戶喜好,,煞有介事地編造不存在的文獻檔案。這種現(xiàn)象被稱為“AI幻覺”,,已經(jīng)成為困擾許多人工智能企業(yè)和使用者的現(xiàn)實難題,。

AI之所以會一本正經(jīng)地胡說八道,根源在于其思維方式與人類存在本質不同,。今天人們?nèi)粘J褂煤徒佑|最多的AI大模型本質上是一個龐大的語言概率預測和生成模型,。它通過分析互聯(lián)網(wǎng)上數(shù)以萬億計的文本,,學習詞語之間的關聯(lián)規(guī)律,,再像玩猜詞游戲一樣,逐字逐句生成看似合理的回答,。這種機制使AI擅于模仿人類的語言風格,,但有時缺乏辨別真?zhèn)蔚哪芰Α?/p>

AI幻覺的產(chǎn)生與大模型訓練的過程密不可分。AI的知識體系基本來源于訓練時“吞下”的數(shù)據(jù)源,。來自互聯(lián)網(wǎng)的各類信息魚龍混雜,,其中不乏虛假信息、虛構故事和偏見性觀點。這些信息一旦成為AI訓練的數(shù)據(jù)源,,就會出現(xiàn)數(shù)據(jù)源污染,。當某個領域專業(yè)數(shù)據(jù)不足時,AI便可能通過模糊性的統(tǒng)計規(guī)律來“填補空白”,。例如,,將科幻小說中的“黑科技”描述為真實存在的技術。隨著AI越來越多地用于信息生產(chǎn),,AI生成的海量虛構內(nèi)容和錯誤信息正在進入訓練下一代AI的內(nèi)容池,,這種“套娃”生態(tài)將進一步加劇AI幻覺的產(chǎn)生。

在大模型訓練過程中,,為了使AI生成滿足用戶需求的內(nèi)容,,訓練者會設置一定的獎勵機制——對于數(shù)學題等需要邏輯推理的問題,往往通過確認答案的正確與否給予獎勵,;對于寫作等開放式命題,,則需要判斷其生成的內(nèi)容是否符合人類寫作習慣。為了訓練效率,,這種判斷更多關注AI語言的邏輯性和內(nèi)容格式等指標,,卻忽略了事實的核查。此外,,訓練過程的缺陷也會導致AI存在“討好”用戶的傾向,,明知道答案不符合事實,也愿意遵照指令生成迎合用戶的內(nèi)容,,并編造一些虛假的例證或看似科學的術語來支撐自己的“假說”,。這種“角色扮演式”的表達讓許多普通用戶難以分辨AI幻覺。上海交通大學媒體與傳播學院進行的一項全國抽樣調查顯示,,約七成受訪者對大模型生成虛假或錯誤信息的風險缺乏清晰認知,。

相關新聞

分析:DeepSeek-R1為何會胡說八道 幻覺率高達14.3%

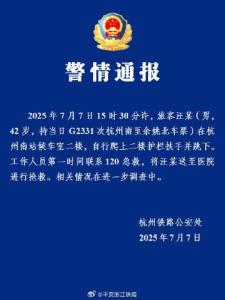

2025-03-01 09:18:29分析一起交通事故為何引發(fā)AI謠言 AI幻覺誤導公眾

近日,,浙江寧波一名駕駛人在彎道違法超車時與摩托車發(fā)生碰撞。事故發(fā)生后,肇事駕駛人沒有第一時間救助傷者,,而是急著下車更換車牌

2025-05-19 21:32:56一起交通事故為何引發(fā)AI謠言一見·這次上??疾欤倳洖楹侮P注人工智能

4月29日,,在上??疾斓牧暯娇倳洠瑏淼缴虾,!澳K倏臻g”大模型創(chuàng)新生態(tài)社區(qū)調研,。

2025-04-30 13:23:05一見·這次上海考察張德培:中國球員的優(yōu)異成績會產(chǎn)生積極影響

2025-01-03 07:57:40中國球員的優(yōu)異成績會產(chǎn)生積極影響取消公攤面積會產(chǎn)生什么影響 市場透明度提升

2024-12-20 14:53:57取消公攤面積會產(chǎn)生什么影響人工智能會取代你的工作嗎 職業(yè)未來變數(shù)與應對策略

2025-02-18 13:16:43人工智能會取代你的工作嗎