AI仿冒名人帶貨屬違法行為 深度偽造技術(shù)隱患顯現(xiàn)

如今,,從智能家居的語音助手到自動駕駛汽車,,從高效能的數(shù)據(jù)分析到醫(yī)療領(lǐng)域的精準(zhǔn)診斷,AI正以前所未有的方式改變著世界,。然而,,隨著AI技術(shù)的不斷發(fā)展和應(yīng)用,,其雙刃劍的特性也逐漸顯現(xiàn)。深度偽造技術(shù)就是其中之一,,它利用人工智能算法生成高度逼真的虛假視頻或圖像,,通過深度學(xué)習(xí)算法分析大量真實數(shù)據(jù),學(xué)習(xí)特定人物或場景的特征,,并生成與之極為相似的虛假內(nèi)容,。這種技術(shù)使得造假變得更加容易和難以辨別,給社會帶來了諸多安全隱患,。

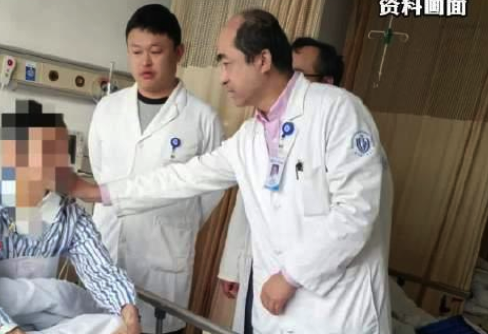

今年以來,,AI深度偽造假冒名人的事件時有發(fā)生。不久前,,有人利用AI技術(shù)深度偽造了張文宏醫(yī)生的臉部和聲音進行直播帶貨,。在這段視頻中,被合成的人像反復(fù)介紹一種產(chǎn)品,,聲音也很像張文宏本人,,商品中的蛋白棒產(chǎn)品已經(jīng)售賣了1200多件。目前該賬號已經(jīng)搜索不到,。張文宏醫(yī)生對有人利用AI模仿自己帶貨的行為非常氣憤,,表示這種情況已經(jīng)持續(xù)了幾個星期,尤其是對于不熟悉AI技術(shù)的年長市民,,他們很容易相信這些虛假信息,。

用AI制作假冒名人欺騙網(wǎng)民的現(xiàn)象并非個例,。今年國慶期間,有人用企業(yè)家雷軍的聲音和頭像制作了眾多惡搞視頻,。還有人利用劉德華的聲音為自己增加流量,。該視頻出現(xiàn)后,劉德華電影公司連續(xù)發(fā)布兩則聲明,,提醒各方人士注意,,避免落入偽造劉德華聲音的AI語音合成技術(shù)騙局。上海市消保委也注意到最近日益增加的AI假冒名人的視頻,,認為這種行為是對消費者合法權(quán)益的侵害,,是一種赤裸裸的欺詐行為。

現(xiàn)在的AI技術(shù)在克隆他人面部和聲音上已經(jīng)非常成熟,,提供一張照片就能做出換臉的效果,,他人的聲音也能被輕易模仿。專家介紹,,通過人工智能技術(shù)可以將臉進行替換,聲音需要有一個語言模型,,將被模仿者的聲音進行合成,,實現(xiàn)音色的克隆。技術(shù)人員現(xiàn)場做了一個測試,,將事先錄制好的視頻換成記者的臉和聲音,。記者提供了一張證件照片,不到兩分鐘,,通過軟件的渲染,,視頻的人臉就換成了記者的臉。隨后是聲音的AI制作,,記者現(xiàn)場錄制了一段聲音輸入到AI資料庫中,,很快AI就能用記者的聲音播報任何文本內(nèi)容。最終合成的視頻效果非常逼真,。

盡管AI模仿度高,,但并非毫無破綻。專家表示,,這種既要換臉又要換聲的操作只能制作視頻,,無法做到實時直播。觀眾通過仔細辨認視頻,,也能看出AI的痕跡,。辨別時可以重點關(guān)注視頻中人臉的變換,包括人臉輪廓和背景環(huán)境融合度,、協(xié)調(diào)度等,。另外,,在語音、語速和口型的匹配度上也可以去重點關(guān)注,。

未經(jīng)授權(quán)利用AI假冒他人屬違法行為,。專家表示,那些未經(jīng)允許使用他人形象的行為均屬于違法行為,。按照民法典的規(guī)定,,未經(jīng)權(quán)利人同意,任何人不得侵害他人的人格權(quán)利,。不僅不能直接使用,,也不能使用當(dāng)事人的人臉信息、聲音信息進行深度合成,。如果把相關(guān)視頻,,包括聲音編輯之后形成了相關(guān)內(nèi)容,這屬于偽造的信息,,按照網(wǎng)絡(luò)安全法的規(guī)定,,這屬于違法信息。此外,,AI假冒名人發(fā)表自己的作品,,有可能會追究發(fā)布者的刑事責(zé)任。

專家表示,,AI假冒名人進行帶貨這樣的行為已經(jīng)涉嫌違法,,一旦消費者信以為真購買了產(chǎn)品,可以要求商家退一賠三,。消費者權(quán)益保護法明確規(guī)定,,如果消費者遭到了欺詐,可以要求不法商家進行賠償,。具體的賠償標(biāo)準(zhǔn)是退一賠三,,如果不足500元,消費者完全可以要求商家按照500元進行賠償,。短視頻平臺也應(yīng)該擔(dān)負主體責(zé)任,,有義務(wù)防范AI假冒名人視頻在自己的平臺大量傳播。如果發(fā)現(xiàn)利用AI合成的聲頻和視頻傳播虛假消息,,應(yīng)當(dāng)對發(fā)布者采取包括信用管理在內(nèi)的強制措施,,根據(jù)信用的降低,要隨之產(chǎn)生必要的處罰措施,。

相關(guān)新聞

AI仿冒名人帶貨屬違法行為 消費者可要求退一賠三

2024-12-23 07:43:53退一賠三央視揭AI假冒名人帶貨亂象 深度偽造頻發(fā)

2024-12-23 15:10:02央視揭AI假冒名人帶貨亂象記者實測AI換臉搭配聲音合成 揭秘假冒名人帶貨亂象

2024-12-23 13:42:45記者實測AI換臉搭配聲音合成堵車時闖綠燈屬違法行為

2024-12-02 10:38:26堵車時闖綠燈屬違法行為張文宏“被AI帶貨”,,監(jiān)管如何跟上技術(shù)發(fā)展,?

2024-12-14 15:08:21張文宏“被AI帶貨”堵車時闖綠燈屬違法行為 影響通行效率

2024-12-02 10:13:03堵車時闖綠燈屬違法行為