全球掀DeepSeek復(fù)現(xiàn)狂潮 硅谷巨頭神話崩塌,!

硅谷正經(jīng)歷由中國公司引發(fā)的重大變革。全美都在擔(dān)憂全球人工智能的中心是否已經(jīng)轉(zhuǎn)向中國,。此時(shí),,全球范圍內(nèi)掀起了復(fù)現(xiàn)DeepSeek模型的熱潮。正如LeCun所說:“這是開源對(duì)閉源的一次勝利,?!边@些討論引發(fā)了人們對(duì)數(shù)百億美元支出必要性的質(zhì)疑,甚至有人預(yù)測(cè)中國量化基金可能會(huì)導(dǎo)致納斯達(dá)克崩盤,。

未來,,大模型時(shí)代可能進(jìn)入一個(gè)分水嶺:高性能模型不再僅限于算力巨頭,而是每個(gè)人都能擁有,。UC伯克利博士生潘家怡及其團(tuán)隊(duì)在CountDown游戲中復(fù)現(xiàn)了DeepSeek R1-Zero,,結(jié)果令人滿意。實(shí)驗(yàn)表明,,通過強(qiáng)化學(xué)習(xí),,3B的基礎(chǔ)語言模型也能自我驗(yàn)證和搜索,成本不到30美元即可見證“啊哈”時(shí)刻,。該項(xiàng)目名為TinyZero,,采用R1-Zero算法,給定基礎(chǔ)語言模型,、提示和真實(shí)獎(jiǎng)勵(lì)信號(hào)后運(yùn)行強(qiáng)化學(xué)習(xí),。模型從簡(jiǎn)單輸出開始,,逐步進(jìn)化出自我糾正和搜索策略。

消融實(shí)驗(yàn)中,,研究人員使用了Qwen-2.5-Base的不同參數(shù)規(guī)模(0.5B,、1.5B、3B,、7B),。結(jié)果顯示,0.5B模型只能猜測(cè)解決方案,,而從1.5B開始,,模型學(xué)會(huì)了搜索、自我驗(yàn)證和修正解決方案,,從而獲得更高分?jǐn)?shù),。研究還發(fā)現(xiàn),額外的指令微調(diào)并非必要,,這支持了R1-Zero的設(shè)計(jì)決策,。此外,具體的RL算法并不重要,,PPO,、GRPO、PRIME等算法都能帶來不錯(cuò)的性能表現(xiàn),。

港科大助理教授何俊賢的團(tuán)隊(duì)僅用8K樣本,,在7B模型上復(fù)現(xiàn)了DeepSeek-R1-Zero和DeepSeek-R1的訓(xùn)練,取得了顯著成果,。他們?cè)贏IME基準(zhǔn)上實(shí)現(xiàn)了33.3%的準(zhǔn)確率,,在AMC上為62.5%,在MATH上為77.2%,。這一表現(xiàn)不僅超越了Qwen2.5-Math-7B-Instruct,,還能與使用更多數(shù)據(jù)和復(fù)雜組件的PRIME和rStar-MATH相媲美。他們使用純PPO方法訓(xùn)練Qwen2.5-7B-SimpleRL-Zero,,并采用MATH數(shù)據(jù)集中的8K樣本,。Qwen2.5-7B-SimpleRL則先進(jìn)行Long CoT監(jiān)督微調(diào),再進(jìn)行強(qiáng)化學(xué)習(xí),。兩種方法都只使用相同的8K MATH樣本,。在第44步時(shí),模型出現(xiàn)了自我反思能力,,并表現(xiàn)出更長(zhǎng)的CoT推理能力,。

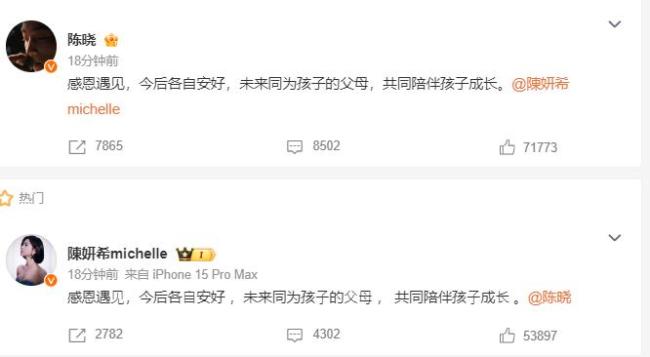

HuggingFace團(tuán)隊(duì)也宣布復(fù)刻DeepSeek R1的所有流程,并將所有訓(xùn)練數(shù)據(jù)和腳本開源。項(xiàng)目命名為Open R1,,發(fā)布一天內(nèi)獲得了超過1.9k星標(biāo)和142個(gè)fork,。DeepSeek的成功使其成為美國頂尖高校研究人員的首選模型,甚至取代了一些人對(duì)ChatGPT的需求,。這次,,中國AI確實(shí)震撼了世界。

相關(guān)新聞

DeepSeek 引發(fā)全球熱議的神秘力量

2025-02-02 11:56:34DeepSeekDeepSeek掀算力革命 推動(dòng)國產(chǎn)AI芯片發(fā)展

2025-02-07 12:10:50DeepSeek掀算力革命實(shí)測(cè)DeepSeek做奧數(shù)題寫作文 DeepSeek火爆全球

2025-01-27 20:13:31實(shí)測(cè)DeepSeek做奧數(shù)題寫作文DeepSeek掀起算力新范式 低成本訓(xùn)練引領(lǐng)變革

2025-01-27 19:43:28DeepSeek掀起算力新范式DeepSeek刷屏全球 現(xiàn)象級(jí)產(chǎn)品崛起

2025-02-12 15:41:17DeepSeek刷屏全球多國給DeepSeek使用設(shè)限 數(shù)據(jù)安全引發(fā)全球關(guān)注

2025-01-30 19:34:04多國給DeepSeek使用設(shè)限