英偉達(dá)創(chuàng)滿血DeepSeek推理世界紀(jì)錄 性能顯著提升

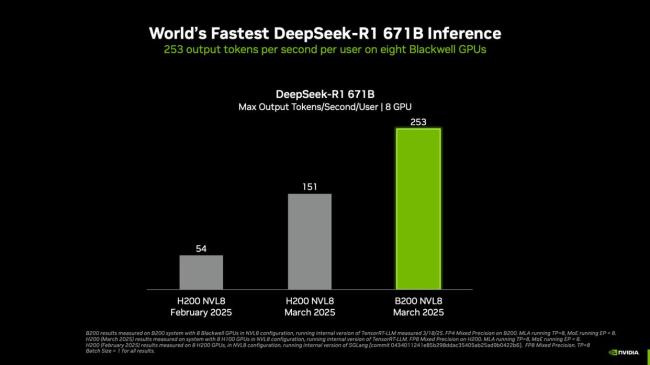

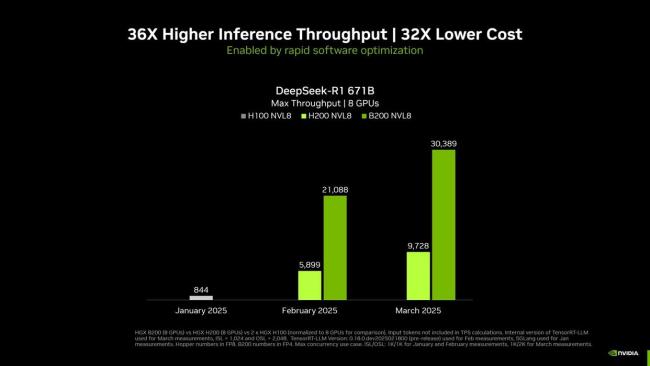

英偉達(dá)在NVIDIA GTC 2025上宣布,其NVIDIA Blackwell DGX系統(tǒng)創(chuàng)下DeepSeek-R1大模型推理性能的世界紀(jì)錄,。在搭載了八塊Blackwell GPU的單個(gè)DGX系統(tǒng)上運(yùn)行6710億參數(shù)的滿血DeepSeek-R1模型可實(shí)現(xiàn)每用戶每秒超250 token的響應(yīng)速度,,系統(tǒng)最高吞吐量突破每秒3萬token,。

隨著NVIDIA平臺繼續(xù)在最新的Blackwell Ultra GPU和Blackwell GPU上突破推理極限,,其性能將會不斷提高,。例如,,在運(yùn)行TensorRT-LLM軟件的NVL8配置的NVIDIA B200 GPU上,,單節(jié)點(diǎn)配置為DGX B200(8塊GPU)與DGX H200(8塊GPU),,測試參數(shù)為輸入1024 token / 輸出2048 token,;此前測試為輸入/輸出各1024 token,計(jì)算精度方面,,B200采用FP4,,H100/H200采用FP8精度。

自2025年1月以來,,通過硬件和軟件的結(jié)合,,英偉達(dá)成功將DeepSeek-R1 671B模型的吞吐量提高了約36倍。節(jié)點(diǎn)配置包括DGX B200(8塊GPU),、DGX H200(8塊GPU)以及兩個(gè)DGX H100(8塊GPU)系統(tǒng),,測試參數(shù)依然采用TensorRT-LLM內(nèi)部版本,輸入1024 token / 輸出2048 token,,并發(fā)性MAX,,計(jì)算精度方面,B200采用FP4,,H100/H200采用FP8精度,。

與Hopper架構(gòu)相比,Blackwell架構(gòu)與TensorRT軟件相結(jié)合實(shí)現(xiàn)了顯著的推理性能提升,。DGX B200平臺在運(yùn)行TensorRT軟件并使用FP4精度時(shí),,與DGX H200平臺相比提供了3倍以上的推理吞吐量提升,適用于包括DeepSeek-R1,、Llama 3.1 405B和Llama 3.3 70B在內(nèi)的多個(gè)模型,。在對模型進(jìn)行量化以利用低精度計(jì)算優(yōu)勢時(shí),確保精度損失最小化是生產(chǎn)部署的關(guān)鍵,。在DeepSeek-R1模型上,,相較于FP8基準(zhǔn)精度,TensorRT Model Optimizer的FP4訓(xùn)練后量化技術(shù)在不同數(shù)據(jù)集上僅產(chǎn)生微乎其微的精度損失,。

相關(guān)新聞

黃仁勛揭秘下一代芯片Rubin,英偉達(dá)想要吃“DeepSeek紅利” 推理時(shí)代的新機(jī)遇

2025-03-19 12:03:54黃仁勛揭秘下一代芯片Rubin英偉達(dá)上線DeepSeek 領(lǐng)先推理模型預(yù)覽版發(fā)布

2025-02-01 01:41:22英偉達(dá)上線DeepSeek英偉達(dá)稱DeepSeek離不開其芯片 市場需求增加

1月28日,,全球多家科技巨頭因DeepSeek的技術(shù)進(jìn)步而受到影響,英偉達(dá)的股價(jià)在美股市場收跌16.86%,,每股報(bào)18.58美元

2025-01-28 18:22:15英偉達(dá)稱DeepSeek離不開其芯片英偉達(dá):DeepSeek未來需要更多芯片 市場需求旺盛

2025-01-28 11:24:53英偉達(dá)DeepSeek崛起沖擊美股 英偉達(dá)股價(jià)大跌17%

2025-01-28 07:17:05美股DeepSeek繼續(xù)給巨頭上壓力 英偉達(dá)業(yè)績超預(yù)期

2025-02-28 18:41:01DeepSeek繼續(xù)給巨頭上壓力