大模型集體失智:9.11和9.9哪個(gè)大,,幾乎全翻車(chē)了

大模型集體失智:9.11和9.9哪個(gè)大,,幾乎全翻車(chē)了

近期,一個(gè)看似簡(jiǎn)單的數(shù)學(xué)問(wèn)題挑戰(zhàn)了眾多前沿的人工智能大模型,引發(fā)了業(yè)界的關(guān)注,。問(wèn)題本身并不復(fù)雜:9.11和9.9哪個(gè)數(shù)字更大,?然而,,在第一財(cái)經(jīng)記者的測(cè)試中,,即便是先進(jìn)的AI系統(tǒng)也出現(xiàn)了分歧。在12款接受測(cè)試的大模型中,,只有阿里通義千問(wèn),、百度文心一言、Minimax和騰訊元寶給出了正確的答案,,剩余八款模型,,包括知名的ChatGPT-4o等,則在這個(gè)基礎(chǔ)數(shù)學(xué)問(wèn)題上栽了跟頭,。

這些出錯(cuò)的大模型大多陷入了比較小數(shù)點(diǎn)后數(shù)字的誤區(qū),,誤以為9.11大于9.9。即使記者明確指出是在數(shù)學(xué)的語(yǔ)境下進(jìn)行比較,,類(lèi)似ChatGPT這樣的頂尖大模型也未能避免錯(cuò)誤,。這揭示了長(zhǎng)久以來(lái)大模型在處理數(shù)學(xué)問(wèn)題上的不足,反映出它們的設(shè)計(jì)更偏向于文字處理而非數(shù)字邏輯,。

該現(xiàn)象的起因可追溯至一檔綜藝節(jié)目中的投票率比較,,觀眾對(duì)13.8%與13.11%的大小產(chǎn)生爭(zhēng)議,進(jìn)而引發(fā)了公眾對(duì)AI處理此類(lèi)基本數(shù)學(xué)問(wèn)題能力的好奇和測(cè)試,。測(cè)試結(jié)果顯示,,許多AI在面對(duì)這類(lèi)基礎(chǔ)數(shù)學(xué)問(wèn)題時(shí)顯得力不從心,盡管它們?cè)趶?fù)雜的語(yǔ)言任務(wù)上表現(xiàn)出色,。

探究其背后的原因,,專(zhuān)家們指出,生成式語(yǔ)言模型的本質(zhì)決定了它們更擅長(zhǎng)處理基于文本的關(guān)聯(lián)性任務(wù),,而非數(shù)學(xué)所需的邏輯推理和精確計(jì)算,。語(yǔ)言模型通過(guò)學(xué)習(xí)海量文本數(shù)據(jù)來(lái)預(yù)測(cè)下一個(gè)詞,這使得它們?cè)谖膶W(xué)創(chuàng)作上能夠展現(xiàn)出接近人類(lèi)的水平,,但在需要嚴(yán)謹(jǐn)邏輯和抽象思維的數(shù)學(xué)領(lǐng)域,,卻顯得力有未逮。此外,,數(shù)字處理時(shí)的分詞問(wèn)題也是導(dǎo)致錯(cuò)誤的一個(gè)技術(shù)因素,,現(xiàn)有分詞器往往沒(méi)有針對(duì)數(shù)學(xué)計(jì)算進(jìn)行優(yōu)化,可能導(dǎo)致數(shù)字被錯(cuò)誤分割,,影響模型的理解,。

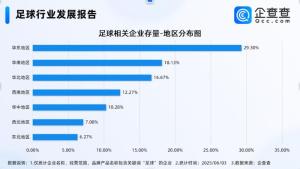

為改善這一狀況,,有觀點(diǎn)認(rèn)為,針對(duì)性的語(yǔ)料訓(xùn)練能夠逐步提升大模型的理科能力,,特別是通過(guò)構(gòu)造包含數(shù)學(xué)問(wèn)題解決過(guò)程的數(shù)據(jù)集來(lái)增強(qiáng)模型的數(shù)學(xué)推理能力,。隨著AI技術(shù)的發(fā)展,未來(lái)大模型的訓(xùn)練或?qū)⒏幼⒅亟Y(jié)構(gòu)化和專(zhuān)業(yè)領(lǐng)域的數(shù)據(jù)構(gòu)建,,以確保它們能夠在需要精確計(jì)算和復(fù)雜推理的場(chǎng)景中發(fā)揮可靠作用,比如金融分析,、工業(yè)報(bào)告解讀等領(lǐng)域,。這不僅是提高模型準(zhǔn)確性的需求,也是推動(dòng)AI技術(shù)在更多高要求場(chǎng)景中實(shí)現(xiàn)有效落地的關(guān)鍵,。

大模型集體失智:9.11和9.9哪個(gè)大,,幾乎全翻車(chē)了。

相關(guān)新聞

大模型測(cè)不出9.11和9.9哪個(gè)大 AI常識(shí)困境暴露

2024-07-17 13:58:59大模型測(cè)不出9.11和9.9哪個(gè)大AI答不出9.11和9.8誰(shuí)大 大模型小學(xué)數(shù)學(xué)集體翻車(chē)

2024-07-17 20:40:10AI答不出9.11和9.8誰(shuí)大北京網(wǎng)友測(cè)試教育大模型9.9比9.11大 8大模型犯錯(cuò)揭示短板

近期,,一個(gè)看似簡(jiǎn)單的數(shù)學(xué)問(wèn)題挑戰(zhàn)了眾多先進(jìn)的人工智能大模型,引發(fā)了業(yè)界關(guān)注

2024-07-19 08:05:47北京網(wǎng)友測(cè)試教育大模型9.9比9.11大恒大“擔(dān)保人”,,果然翻車(chē)了,?

2024-04-16 10:57:14恒大“擔(dān)保人”臺(tái)灣93歲老人因病失智 一直喊媽媽 親情穿越失智的呼喚

2024-05-24 15:52:58臺(tái)灣93歲老人因病失智銷(xiāo)量暴跌,,去年排名第一的手機(jī),,又翻車(chē)了?realme困局:叫好不叫座

2024-06-08 15:25:53銷(xiāo)量暴跌