DeepSeek發(fā)新成果 稀疏注意力機(jī)制NSA顯著提升長上下文處理速度(2)

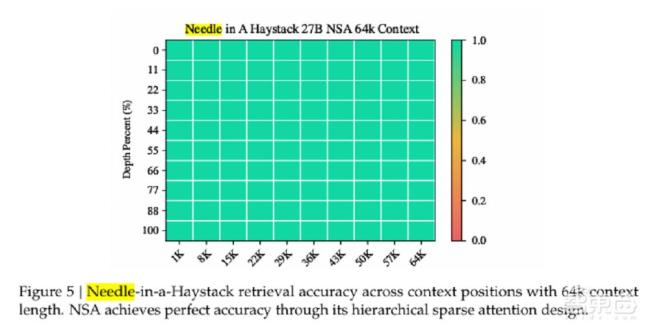

長文本建模是下一代語言模型的關(guān)鍵能力,,但傳統(tǒng)注意力機(jī)制的高復(fù)雜度限制了其在長序列上的應(yīng)用,。例如,在解碼64k長度的上下文時(shí),,注意力計(jì)算占據(jù)了總延遲的70%至80%,。因此,,稀疏注意力機(jī)制應(yīng)運(yùn)而生,通過選擇性計(jì)算關(guān)鍵的查詢鍵對來減少計(jì)算開銷,。然而,,許多稀疏注意力方法在實(shí)際推理中未能顯著降低延遲。

一些方法僅在自回歸解碼階段應(yīng)用稀疏性,,而預(yù)填充階段仍需進(jìn)行密集計(jì)算,;另一些方法僅關(guān)注預(yù)填充階段的稀疏性,導(dǎo)致在某些工作負(fù)載下無法實(shí)現(xiàn)全階段加速,。還有部分稀疏方法無法適應(yīng)現(xiàn)代高效的解碼架構(gòu),,導(dǎo)致KV緩存訪問量仍然較高,,無法充分發(fā)揮稀疏性優(yōu)勢。此外,,現(xiàn)有的稀疏注意力方法大多僅在推理階段應(yīng)用稀疏性,,缺乏對訓(xùn)練階段的支持。

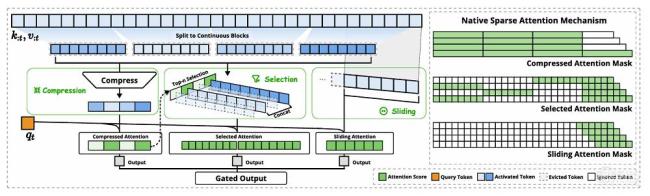

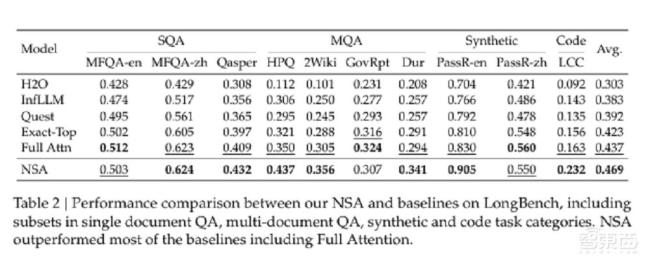

NSA旨在通過針對硬件特點(diǎn)的推理加速和適用于訓(xùn)練的算法設(shè)計(jì),,填補(bǔ)這一空白,。NSA的核心思想是通過動(dòng)態(tài)分層稀疏策略,結(jié)合粗粒度的token壓縮和細(xì)粒度的token選擇,,以保留全局上下文感知能力和局部精確性,。NSA將輸入序列通過三個(gè)并行的注意力分支處理:壓縮注意力、選擇性注意力和滑動(dòng)窗口注意力,。壓縮注意力通過將鍵和值聚合成塊級表示來捕捉粗粒度的語義信息,,減輕注意力計(jì)算負(fù)擔(dān)。選擇性注意力通過塊選擇機(jī)制保留重要的細(xì)粒度信息,,顯著降低了計(jì)算負(fù)擔(dān),?;瑒?dòng)窗口注意力專注于局部上下文信息,,防止模型過度依賴局部模式。

相關(guān)新聞

《唐探1900》發(fā)新預(yù)告 歡喜冤家大顯神通

2025-01-22 11:03:57唐探1900發(fā)新預(yù)告DeepSeek在自動(dòng)駕駛中有何優(yōu)勢 車圈刮起“DeepSeek風(fēng)”

2025-02-18 06:34:40DeepSeek在自動(dòng)駕駛中有何優(yōu)勢實(shí)測DeepSeek做奧數(shù)題寫作文 DeepSeek火爆全球

2025-01-27 20:13:31實(shí)測DeepSeek做奧數(shù)題寫作文《射雕英雄傳:俠之大者》發(fā)新預(yù)告 鐵血丹心喚武俠情懷

1月25日,,武俠電影《射雕英雄傳:俠之大者》發(fā)布了“鐵血丹心”特別預(yù)告

2025-01-26 10:53:15射雕英雄傳以對貝魯特發(fā)新撤離令 以軍空襲接踵而至

2024-10-10 21:07:12以對貝魯特發(fā)新撤離令周杰倫宣布暑假要發(fā)新專輯 粉絲興奮期待

2025-02-09 07:41:37周杰倫宣布暑假要發(fā)新專輯