算法沖破算力瓶頸 DeepSeek繼續(xù)開源 推動AI普及與發(fā)展

2月24日和25日,DeepSeek先后宣布開源了FlashMLA代碼和DeepEP通信庫,,致力于推動大模型的開源化進(jìn)程,。DeepSeek-R1模型的問世與開源為大模型行業(yè)帶來了新的希望,,特別是在算力瓶頸方面,。與其他廠商不同,,DeepSeek不僅追求算力疊加,,還通過算法創(chuàng)新解決了困擾行業(yè)的算力問題,。

受DeepSeek影響,,國內(nèi)算力產(chǎn)業(yè)格局發(fā)生變化,AI服務(wù)器出貨量激增,,能支持DeepSeek大模型應(yīng)用的一體機(jī)也變得非常受歡迎,各大廠商紛紛布局,,形成了競爭激烈的市場態(tài)勢,。

自DeepSeek-R1 671B模型開源一個月后,DeepSeek啟動了“Open Source Week”,,計劃在一周內(nèi)開源五個代碼庫。2月24日,,DeepSeek開源了FlashMLA代碼。這是一個MoE訓(xùn)練加速框架,,通過低秩矩陣壓縮KV緩存顯著減少內(nèi)存占用和計算開銷,支持千億參數(shù)模型的高效訓(xùn)練,。浪潮信息相關(guān)負(fù)責(zé)人表示,,相比主流的MHA和GQA算法,F(xiàn)lashMLA在不降低計算精度的情況下大幅減少了推理時的KV緩存占用,,提升了推理效率,。

FlashMLA專為英偉達(dá)Hopper GPU設(shè)計,優(yōu)化了可變長度序列處理,,實現(xiàn)了接近H800理論峰值的性能,。通過FlashMLA,,用戶可以將H800的性能提升到H100的水平,同時降低了大模型部署成本,,推動了大模型在各行業(yè)的落地,。此外,F(xiàn)lashMLA的開源為國產(chǎn)GPU兼容CUDA生態(tài)提供了參考模板,,促進(jìn)了多廠商競爭格局的發(fā)展。

緊接著,,2月25日,,DeepSeek又宣布開源了DeepEP通信庫,。這是第一個用于MoE模型訓(xùn)練和推理的開源EP通信庫,支持低精度運算如FP8格式,。DeepEP通過優(yōu)化All-to-All通信和支持NVLink/RDMA協(xié)議,,實現(xiàn)節(jié)點內(nèi)外高效數(shù)據(jù)傳輸,降低訓(xùn)練和推理延遲,。通過靈活的GPU資源調(diào)度,,DeepEP在通信過程中并行執(zhí)行計算任務(wù),顯著提升整體效率,。

在DeepSeek開源之前,,整個2024年,大模型行業(yè)都陷入了算力焦慮,。高昂的算力成本讓許多企業(yè)望而卻步,,但隨著DeepSeek-R1模型的問世和開源,市場熱情被重新點燃,。除了EP通信庫和FlashMLA的優(yōu)化,,DeepSeek還在多個方面進(jìn)行了算法創(chuàng)新,顯著減少了模型對高算力硬件的依賴,。例如,,通過混合專家架構(gòu)(MoE)和FP8訓(xùn)練技術(shù)優(yōu)化計算效率,,R1模型僅需2048塊GPU即可完成訓(xùn)練,,純算力訓(xùn)練成本降至500多萬美元,遠(yuǎn)低于傳統(tǒng)大模型的數(shù)億美元投入,。

相關(guān)新聞

分析:DeepSeek美股泡沫得以延續(xù) 算法顛覆算力

2025-02-04 21:40:58分析券商:DeepSeek有望引領(lǐng)開源生態(tài) 加速算法-芯片協(xié)同優(yōu)化

廣發(fā)證券指出,,大模型的核心競爭力在于算法、算力和數(shù)據(jù)的協(xié)同進(jìn)化

2025-02-22 00:18:26券商DeepSeek沒能讓算力焦慮消失 國產(chǎn)算力迎來利好

2025-02-11 08:24:36DeepSeek沒能讓算力焦慮消失DeepSeek概念透露,,誰是算力之王? AI算力競爭加劇

2025-02-16 15:37:02DeepSeek概念透露賽道Hyper | DeepSeek:算力需求的潛在邏輯

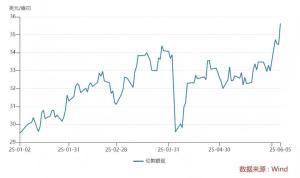

1月27日,英偉達(dá)美股盤前深度下跌超過12%,,跌破了2024年12月17日的126.86美元低點,。黃仁勛可能沒想到,撼動英偉達(dá)產(chǎn)業(yè)邏輯的是一家中國私募

2025-01-29 02:35:57從DeepSeek看算力需求的潛在邏輯DeepSeek推動AI平權(quán) 國產(chǎn)算力迎來價值重估 改變算力格局

2025-02-28 09:30:11DeepSeek推動AI平權(quán)國產(chǎn)算力迎來價值重估